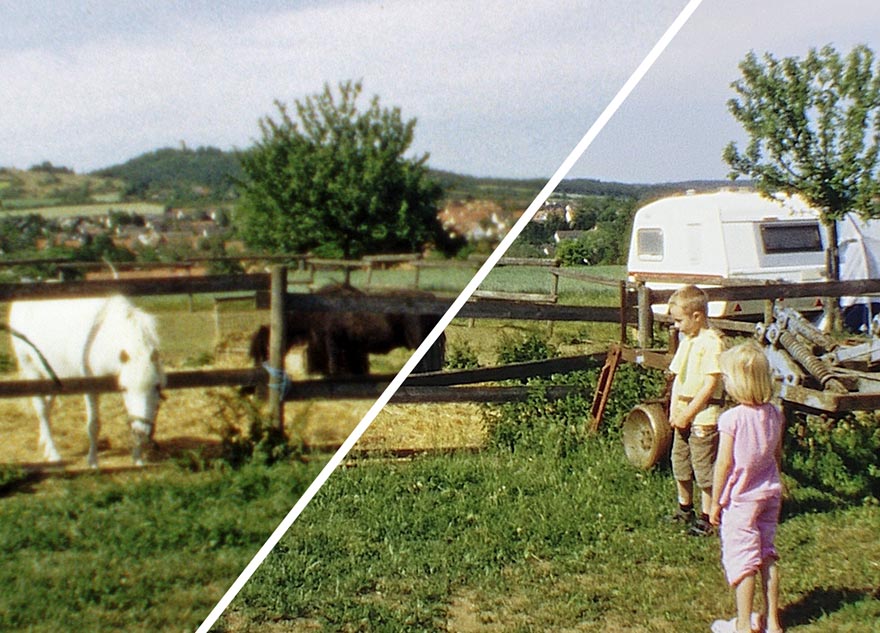

Links ein eizeln abgetastetes Super 8 Einzelbild, rechts eine durch SR errechnete Simulation dessen, was unser Auge bei der Projektion wahrnimmt

Wie kommt es eigentlich, dass projizierter Film so unendlich viel besser aussieht als jede noch so teure Abtastung? Wieso erscheint uns die Super-8-Nahaufnahme auf der Leinwand knackscharf, wo doch kein einziges Einzelbild in der Vergrößerung scharf erscheint? Wieso sehen Farben und Kontrast nach der Abtastung oft so enttäuschend aus, während das projizierte Original trotz Fehlbelichtung in der Projektion noch erfreute? Warum entsteht bei gut belichtetem und projiziertem Schmalfilm so viel mehr Kinogefühl als bei jeder teuer abgetasteten Version auf DVD?

Die Antwort auf alle diese Fragen liegt in der Natur der Sache. Sie ist in der Funktionsweise des analogen Laufbildfilms begründet, die sich in wesentlichen Punkten von der digitalen Konserve bewegter Bilder unterscheidet. So sichtbar diese Systemunterschiede in der Vorführung werden, so wenig offensichtlich sind sie bei einer oberflächlichen Betrachtung der Aufnahmeprinzipien. Wir müssen daher etwas genauer hinsehen. Das Geheimnis des Films liegt nämlich „zwischen den Zeilen“.

Drei Unterschiede

Film unterscheidet sich in drei wesentlichen Punkten von seinem digitalen Pendant: Er besteht aus vollwertigen, unkomprimierten Einzelbildern. Er hat kein festes, durch Sensoren vorgegebenes Raster mit Bildpunkten. Er hat einen ungleich größeren Farbraum. Das bedeutet: Farbumkehrfilm kann Farben wiedergeben, die sich auch mit teuren digitalen Kameras nicht einfangen lassen und ebenso schwierig wiedergegeben werden können.

Schon nach diesen Feststellungen hört man oft viele vermeintliche Gegenargumente. „Die Kompression sieht man aber doch nicht, wenn sie richtig gemacht ist“. Oder: „Die Auflösung einer HD-Kamera ist wesentlich höher als die von Super-8-Film.“ Oder: „Mein Beamer kann aber den ganzen sRGB Farbraum“. Der grundsätzliche Denkfehler hierbei ist: Es wird nur das Einzelbild betrachtet und verglichen, nicht das Ergebnis, das letztendlich wahrgenommen wird. Wie auch? Wahrnehmung kann man ja schwer messen. Übersehen wird dabei immer, welche Rolle das Gehirn spielt und was es beim Sehen allgemein leistet.

Vergessen wir mal kurz Film, Kamera und HD-Bildsensor komplett. Betrachten wir das menschliche Auge. Es ist ein Zweilinser in einer Gruppe, feste Brennweite, Blende von ca. 5,6-16 regulierbar. Einstellbar von ca. 20 cm bis unendlich durch sagenhaft schnellen Autofocus. Verzeichnung und störende stürzende Linien kennt es offenbar auch nicht. Die Lichtstrahlen treffen auf unsere Netzhaut, einem gewölbten Sensor mit ca. 6 Mio. tageslichtempfindlichen Rezeptoren, angeborenem blindem Fleck und gefühlten 25-2000 ASA variabler Empfindlichkeit. Unsere Augen sind offenbar so leistungsfähig, dass wir mit ihrer Hilfe winzige Details wie Staubkörner oder Filmkorn erkennen können. Wir können mit ihrer Hilfe sogar die Qualität von Objektiven der 1000- oder auch 3000-€-Klasse beurteilen!

Moment mal. Diese beiden Glubschklumpen aus organischem Material mit einem miesem Brechungsindex von etwa 1,4… [Der Brechungsindex beschreibt optische Materialeigenschaften, je höher die Zahl, desto stärker bricht das Material das Licht. Optische Gläser haben einen Brechungsindex von 1,5-2,3, sind – salopp gesagt – also wesentlich effizienter] sollen also genauer und besser sein als das kiloschwere Angenieux-Zoom oder das Leica Noctilux? Keine Sorge, rein optisch gesehen sind sie es nicht. Das auf der Netzhaut produzierte Abbild der Wirklichkeit ist sogar erbärmlich schlecht. Es ist unser Gehirn, das ohne spürbare Anstrengungen die eingehenden Reize zu einer beachtlichen optischen Wahrnehmung verarbeitet. In unserer Sprache ist diese Tatsache fest verankert. Man „schärft den Blick“, in dem man auf ein besonderes Muster oder Objekt trainiert wird. Man sagt „Tunnelblick“, wenn einer nur noch eine Sache im Kopf hat. Wer alles unter Kontrolle hat, hat gar den „Überblick“. Eine neue Erkenntnis „öffnet einem die Augen“. Oder man „sieht den Wald vor lauter Bäumen nicht“. Über Dinge, die man nicht sehen will, „schaut man hinweg“ oder „verschließt die Augen“.

Das Gehirn bringt Schärfe

Und wie gelingt es dem Gehirn nun, aus den qualitativ sehr mäßigen Informationen unserer beiden Sehnerven scheinbar mühelos ein messerscharfes und sogar dreidimensionales Bild zu erzeugen? Es assoziiert, es arbeitet mnemonisch – auch Gedächtnistraining genannt. Jeder kennt das: Lernt man ein neues Wort, liest man es plötzlich überall. Das Gesicht eines guten Freundes erkennen wir in der Menge viel schneller als das eines flüchtigen Bekannten. Füttern wir unser Gehirn nun mit einer gewissen Frequenz mit Einzelbildern, interpoliert es daraus die nahezu gleichen Eindrücke wie die, die unsere Augen in der Wirklichkeit wahrnehmen. Wir nehmen so Dinge wahr, die auf keinem einzelnen Filmbild zu sehen sind. Wir lesen quasi zwischen den Zeilen (Phi-Effekt).

Erst seit jüngster Zeit ziehen diese Erkenntnisse auch in einige Softwareprodukte ein, die den abgetasteten Film zum digitalen Movie machen. Man spricht dann von „Super Resolution“ oder kurz SR. SR ist kein Produkt und keine eindeutig definierte Technik, sondern eine Methode, die solche oft übersehenen Nebeneffekte ausnutzt, um eine effektiv weit höhere Informationsdichte zu erzielen, als das einzelne Filmbild sie wiedergeben zu vermag. SR funktioniert etwas eingeschränkt auch mit digitalen Daten, ist aber für unseren Analogfilm prädestiniert. Das Faszinierende: Unser Gehirn benutzt die SR-Methodik bei entsprechendem Input (Projektion echten Films) implizit, einwandfrei und ohne nennenswerte Denkanstrengung!

Hohe Datenredundanz

Grundsätzlich macht sich die SR die hohe Datenredundanz im Film zu nutze. Betrachtet man einen halben Meter Film, enthalten die einzelnen Filmbilder überwiegend gleiche Informationen. Die sogenannten „Codecs“ digitaler Filme machen sich u.a. dieses Phänomen zu Eigen, um die zu speichernde Datenmenge zu reduzieren. Moderne Codecs beschreiben nach einem sogenannten „Keyframe“ (einem vollwertigen Einzelbild mit allen erfassten Bildinformationen ohne Kompressionsverluste) nur noch die Unterschiede zum jeweils vorigen Bild (sogenannte „Delta-Kompression“). Im Idealfall sind das nur Bewegungsvektoren für bestimmte Bildbereiche, „stehende“ Bildausschnitte werden jeweils recycelt. Filmt man zum Beispiel vom Stativ aus ein sprechendes Gesicht, bewegt sich von einem Einzelbild zum nächsten fast nur der Mund des Sprechenden. Bei einer solchen Codierung beschreibt man aber nie alle Veränderungen zum vorigen Bild, sondern nur die relevanten. Auch werden „irrelevante“ Bild-Details (irrelevant, da im Einzelbild unterhalb der Wahrnehmungsgrenze) von solchen Codecs gerne ausgefiltert. Aber Relevanz ist eben relativ…

Das Filmkorn ist da ein gutes Beispiel. Filmkorn ist chaotisch und birgt an sich keine weiteren Bildinformationen, da es nur sich selbst darstellt. Trotzdem ist es für den „Look“ von Film unglaublich wichtig. Bei der SR macht man nun genau das Gegenteil dessen, was so ein Codec zur Reduzierung der Datenrate tut. Man arbeitet idealerweise von vornherein ohne jede verlustbehaftete Kompression, extrahiert also jedes Einzelbild so detailreich und umfassend wie möglich. Kein Korn darf weggerechnet werden, keine Kante Kompressionsartefakte zeigen, kein Schatten darf Klötzchenbildung haben, kein Licht ausfressen und kein Schatten zulaufen. Die Bedeutung des Worts Redundanz kehrt sich hier um: Man lässt nicht Informationen weg, die ja „eh schon vorhanden“ sind, sondern erfasst sie immer wieder erneut, weil sie sich eben geringfügig unterscheiden und in Summe ein feineres Bild zeichnen.

Bei SR mit Analogfilm nutzt man vornehmlich zwei Dimensionen: Die spatiale (räumliche) und die temporale (zeitbasierte). Beide Dimensionen spielen im Analogfilm eine große Rolle: Die Zeitachse, da pro Zeiteinheit n volle, unkomprimierte Einzelbilder vorliegen und die räumliche, da Film kein klares, starres „Raster“ hat, wie es bei jedem CCD oder CMOS Sensor naturgemäß der Fall ist. Beide Dimensionen spielen wunderbar ineinander. Konkret: Warum sehen wir im projizierten S8-Film eindeutig einzelne Haare im Gegenlicht, obwohl doch das Auflösungsvermögen des winzigen Filmbilds viel zu klein ist, um so ein Haar 3- bis 400-fach verkleinert abzubilden? Weil in jedem Filmbild ein paar Silberhalogenidkristalle das Licht dieses einzelnen Haares eingefangen und somit durch die Entwicklung eingefärbt haben. Zwar reichen sie alleine nicht, um das Haar als klare Linie im Filmbild zu zeichnen. Sehen wir jetzt aber 24 oder auch 100 solcher sehr ähnlichen Einzelbilder in schneller Folge hintereinander, verdichten sich die paar eingefärbten Kristalle im Kopf zu genau der Linie, die das Haar beschrieb. Und genau so arbeitet die temporale SR: Sie nutzt die Informationsredundanz der Zeitachse, um viele Informationen des erfassten Zeitraums zu einer erweiterten Information zu verdichten und in jedem erzeugten Einzelbild wiederzugeben. Ein digitales SR-Ergebnis würde als im Idealfall in jedem Einzelbild dieser Szene das Haar so zeigen, wie es sich aus der Summe aller Bilder ergibt.

Blick aufs „i“

Zum spatialen Aspekt betrachten wir mal beispielhaft den Buchstaben “i”, wie er von einem digitalen Sensor gesehen wird und ein Monitor ihn wiedergibt: Ein i, das weiß ein jedes Kind, ist ein Strich mit einem Punkt drüber. Nun lag das hier imaginär gefilmte i aber eben nicht ganz genau auf dem Pixelraster, oder es war eine Spur breiter als jenes. Der Strich des i blutet damit in die benachbarte Pixelspalte rein, sie wird dadurch hellgrau. Der i-Punkt gar, an Schlichtheit kaum zu übertreffen, er besteht plötzlich aus vier unterschiedlich dichten, grauen Quadraten!

Nehmen wir nun an, unser i als Motiv bewege sich absolut nicht, die Kamera sei auf dem Stativ montiert und der Bildstand perfekt. Wir filmen das Motiv nun drei Sekunden lang. Eine digitale Kamera würde 75 absolut identische Einzelbilder liefern (bzw. ein Einzelbild und 74x die Information „sieht genau aus wie eben“). Es gäbe gegenüber dem Einzelbild keinerlei Zusatzinformation durch die temporale Dimension. Unsere analoge Filmkamera würde die Kanten von i-Strich und i-Punkt vielleicht weniger scharf wiedergeben können. Dafür ist sie aber an kein filmübergreifend festes Raster gebunden:

Unser Film würde 72 Bilder liefern, aber jedes wäre ein bisschen anders als das vorige, denn die Kornverteilung ist chaotisch. Ein SR-Algorithmus oder unser Hirn würde schon aus nur fünf dieser unterschiedlichen Bilder dieses Ergebnis berechnen können:

Unser Hirn vermag es viel besser als heutige Software, so zwischen den Zeilen zu lesen. Für uns ist das nicht mal eine Denkanstrengung. Ein Computer hat es da schwerer: Ist der Signal-Rausch-Abstand in kontrastarmen Bereichen (oder bei gepushtem Tri-X) zu niedrig, kann ein Algorithmus partiell Filmkorn mit Motiv verwechseln und so ins Schleudern kommen – dann erzeugt er hässliche Artefakte. Auch kann ein Computer Tiefenunschärfe und Bewegungsunschärfe nur schwer unterscheiden. Durch Unschärfe freigestellte Motivbereiche sollen aber durch SR nicht plötzlich lauter unerwünschte Details zeigen.

Wie „gucken“ Filmabtaster?

Nach diesem kurzen Exkurs in die Wahrnehmungsphysiologie betrachten wir die gängigen Filmabtaster nun aus einer anderen Perspektive. Die meisten etwas ambitionierteren Systeme filmen mit einer synchronisierten Videokamera das Laufbild direkt vom Filmfenster ab. Es entsteht so ein Ausgangssignal, das sowohl einem festgelegten Raster unterliegt als auch (in der Regel verlustbehaftet) komprimiert ist. Spatiale und temporale Auswertung der erfassten Informationen sind damit für Hirn und Software weitgehend unmöglich. Der digitale Output dieser Methode, meist eine AVI-Datei, zeigt zwar flüssige Bewegtbilder – das wahrgenommene Ergebnis steht in seiner Postkartengröße, der unbefriedigenden Bildschärfe und schlechten Motivkontrasten der Wirkung eines projizierten Bild allerdings maßgeblich nach. Leider genügt die Qualität solcher Abtastungen den meisten Kunden offenbar. Wenn man 30 oder 40 Jahre nach ihrer Entstehung die geerbten Schmalfilme mangels „Abspielgerät“ nicht mehr betrachten kann, kaschiert die emotionale Wirkung der ersten Betrachtung nach der Abtastung wohl die suboptimale Qualität des Ergebnisses. Vielleicht unterstreicht das ganze für einige auch schlicht den Retro-Charme. Oma Ilse ist ja immer noch Oma Ilse und zudem plötzlich wieder lebendig.

Eine adäquate Abtastung, im Ergebnis der Bildgüte einer Projektion entsprechend, muss daher anders passieren:

• Jedes Filmbild muss als volles Einzelbild ohne Qualitätsverlust gespeichert werden • Die digitalisierende Kamera muss in allen Disziplinen richtig gut sein. Ihre Auflösung kann kaum hoch genug sein, sie sollte wenig rauschen, ihr Dynamikumfang muss besonders hoch sein. Auch die Optik benötigt einen winzigen Zerstreuungskreis und sollte so hochauflösend wie möglich sein, desweiteren „auf nah“ gerechnet. Nur so erhält man genug Informationen, um erfolgreich zwischen den Zeilen lesen zu können.

Die sogenannten Framescanner, die Bild für Bild vollständig aufzeichnen, sind den Videokamera-basierten Geräten also grundsätzlich schon mal qualitativ voraus, wenn auch dafür meist langsamer arbeitend. Und selbstverständlich muss die gesamte Kette stimmen und zudem auch noch richtig bedient werden – ein ahnungsloser Operator wird auch an der teuersten Telecine-Maschine Schrott produzieren.

Daan Müllers Framescanner

Daan Müller verwendete an seinem Framescanner HM73 zuletzt eine sogenannte Zeilenkamera, die JAI LT-200CL. Diese Kamera benutzt ein hochwertiges Prisma, dichroitische Filter und scannt mit ihren drei einzelnen CMOS-Sensoren immer nur einzelne Zeilen, sodass sich eine Auflösung von echten 2048 x 1 Pixel [Herkömmliche CCD/CMOS Bildsensoren unterscheiden nur hell und dunkel. Um Farben zu unterscheiden, werden die einzelnen Bildpunkte mit roten, blauen und v.a. grünen Mniatur-Filten bestückt. Da zum Bestimmen einer Farbe daher mehrere Pixel zusammengefasst werden müssen (sogenanntes “debayering”), sinkt die effektive Auflösung des Sensors. In einer guten Zeilenkamera wie dieser wird das Licht hinterm Objektiv über ein hochpräzises Prisma in Rot, Grün und Blau-Anteil zerlegt. Drei einzelne Sensorzeilen erfassen so Rot, Grün und Blau simultan und ohne jeglichen Versatz oder Auflösungsverminderung. ] ergibt. Die Pixel liegen durch das Prisma exakt ausgerichtet aufeinander, so dass es keine Farbsäume geben kann. Mit 14μm Kantenlänge hat die JAL-Kamera sehr große Pixel und rauscht entsprechend wenig. Ihr Farbraum ist groß und mit 10 Bit pro Farbkanal vierfach so präzis differenziert wie ein normales Video-Out-Signal.

Die Zeilenkamera ermöglicht aber vor allem einen kontinuierlichen Vortrieb ohne intermittierende Schaltschritte und dadurch auch eine kontinuierliche Beleuchtung. Das ist ein großer Vorteil, denn auch bei noch so kurzer Blitzzeit ist der Film, während eine normale Kamera eines seiner Einzelbilder erfasst, in Bewegung. Für die Schärfe ist das abträglich, eine Zeilenkamera kennt dieses Problem nicht.

Als Ergebnis einer solchen Abtastung von Daan Müller erhielt ich zigtausende von Raw- Dateien auf Festplatte, die ich zunächst von 10 auf 8 Bit pro Farbkanal brachte – leider arbeitet die Software Avisynth, mit der ich mich an die SR herangewagt hatte, nur mit 8 Bit Farbtiefe. Nach dieser Konvertierung lassen sich die Einzelbilder dann echt einfach in ein gänzlich unkomprimiertes .avi zu wandeln, dass als Futter für Avisynth dient.

Arbeit mit Avisynth

Avisynth ist eine sehr mächtige, komplexe, kostenlose, aber auch komplizierte, unübersichtliche und gähnend langsame Plattform für die Bearbeitung von Videodateien. Die mittlerweile legendären Skripte von Freddy Van de Putte sind eine gute Ausgangsbasis, um sich in Avisynth einzuarbieten und Skripte zu erstellen, die gänzlich den eigenen Vorstellungen entsprechen. In meinem Fall verwendete ich bis zu 15 verschiedene Avisynth Plugins, um Daan Müllers Einzelbildern das Maximum an Qualität zu entlocken.

So wird der Bildstand horizontal stabilisiert, in dem die Bildinhalte aneinander ausgerichtet werden. Ohne diesen Schritt ist eine SR nicht ohne weiteres möglich. Danach werden Staub und Kratzer entfernt, was dank der hohen Datenredundanz erstaunlich gut und fehlerfrei gelingt. Ein Staubkorn ist ja meist nur auf einem Einzelbild zu sehen und auf dem nächsten schon wieder verschwunden. Verschiedene Schärfungsalgorithmen und Signalverarbeitungsalgorithmen beziehen Informationen aus den umliegenden Bildern und interpolieren diese zu einem höher aufgelösten Bild. Verschiedene Farb- und Gamma-Korrekturen sowie Beschnitt und Balkung runden das Ergebnis ab.

Das Feld der SR ist ein junges, weites und hochinteressantes. Avisynth geht an das Thema sehr hemdsärmelig und architekturbedingt gähnend langsam heran, liefert aber trotzdem schon verblüffend gute Ergebnisse. Andere für Analogfilm optimierte SR-Software ist mir nicht bekannt, die Landschaft entsprechender Algorithmen wächst aber rasant und bietet stets mehr Möglichkeiten. Die stets zunehmende Leistungsfähigkeit von GPUs ermöglicht immer bessere Ansätze, die auch in Echtzeit arbeiten und mit 16 oder gar 32 Bit Signalinput und Rendertargets arbeiten können.

Holt den Projektor raus!

Einfach ein paar Knöpfe zu drücken reicht nicht, um mit einem Framescanner das Beste an möglicher Qualität aus Schmalfilmen herauszuholen. Die meisten Ergebnisse kommerzieller Anbieter sind im direkten Vergleich zu fachgerechter Projektion daher enttäuschend. Ich rate vielen zur Anschaffung eines gewarteten Projektors, um die alten Schätze wieder vorführen zu können. Der kostet nur den Bruchteil dessen, was man für eine professionelle Abtastung auf den Tisch legen muss. Wer seine Filme aber für die Verbreitung per Internet, DVD oder Blu-ray digitalisieren möchte, sollte entweder einen entsprechend hochpreisigen Profi beauftragen oder selbst mit den Rohdaten weiterarbeiten. Es steckt noch so viel drin im Schmalfilm, was von vielen Dienstleistern beim Abtasten schlichtweg unter den Teppich gekehrt wird.

Related Posts